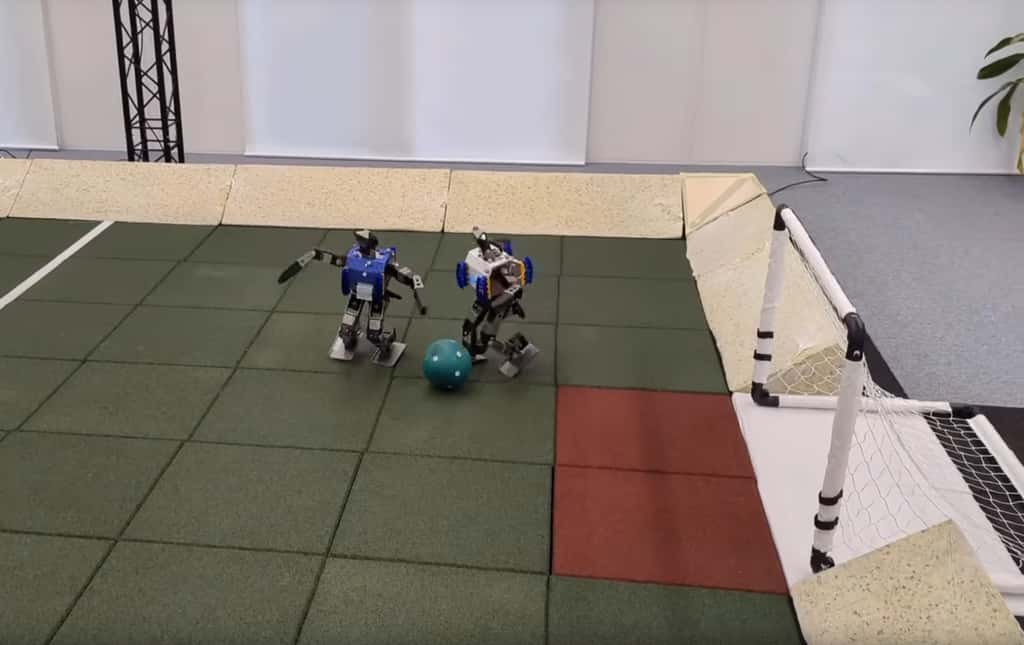

Des chercheurs de Google DeepMind ont appris à des robots humanoïdes à jouer au foot. Grâce à l’apprentissage par renforcement profond, ces petits bipèdes ont appris à marquer des buts et mettre en place une défense en un contre un.

au sommaire

Malgré une révolution dans le monde des intelligences artificielles génératives, la robotique connaît, tout du moins jusqu'à présent, une évolution beaucoup plus lente. Les IA capables de piloter un robot de manière autonome concernent surtout des quadripèdes, comme Spot de Boston Dynamics. Cela pourrait changer grâce à des chercheurs chez Google DeepMind qui ont appris à des robots humanoïdesrobots humanoïdes à jouer au foot.

Côté matériel, les chercheurs ont utilisé des Robotis OP3, de petits robots bipèdes munis de 20 articulationsarticulations. Pour l'IA, ils ont utilisé l’apprentissage par renforcement profond, ou Deep RL (deep reinforcement learning)). Elle a d'abord été entraînée dans des simulations en utilisant le moteur physiquephysique MuJoCo, puis l'IA a été transférée sur les robots dans le monde réel.

Des résultats encourageants

Pour la vision dans le monde réel, les chercheurs ont fait appel à un champ de rayonnement neuronal, ou NeRFNeRF (Neural Radiance Field), une IA capable de créer une représentation 3D de la scène à partir de quelques images en deux dimensions. Les matchs consistent à jouer en un contre un, dans un terrain de quatre mètres par cinq mètres. Les robots ont pour tâche de marquer un but tout en empêchant l'autre de marquer. Ils ont dû apprendre des comportements comme courir, tourner, faire un pas de côté, botter, faire une passe, se relever d'une chute, ou encore interagir avec un objet.

Cette approche par Deep RL a permis à l'IA de marquer 10 buts sur 10 dans la simulation, et 6 sur 10 dans le monde réel. Comparé à un comportement préprogrammé, le robot était notamment capable de marcher 156 % plus rapidement, a mis 63 % moins de temps pour se relever et a pu donner des coups de pied 24 % plus rapidement. De plus, une vidéo montre que les robots peuvent être poussés de nombreuses fois, ils parviennent toujours à se relever et à continuer à poursuivre le ballon. Pour les chercheurs, ces résultats sont encourageants et des méthodes similaires pourraient s'appliquer à de plus grands robots.